ICCHP 2020: Réalité augmentée pour les malvoyants

Auteur: Technologie et Innovation / SBV / Décembre 2020

Titre-Originale: «Augmented Reality for People with Low Vision: Symbolic and Alphanumeric Representation of Information» (Florian Lang, Albrecht Schmidt, und Tonja Machulla)

Nombre de moyens auxiliaires pour les personnes malvoyantes utilisent trop peu les possibilités offertes par les évolutions techniques. Des lunettes de réalité augmentée sont en mesure de fournir des informations difficilement perceptibles dans un format visuel souhaité par l’utilisateur.

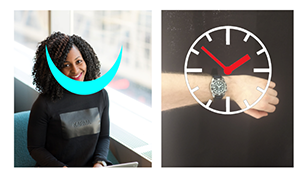

Les chercheurs de l’Université Ludwig-Maximilian à Munich planchent sur une application de réalité augmentée avec laquelle il devrait être possible de reconnaître des expressions faciales et de les représenter sous forme agrandie dans une paire de lunettes idoine. L’app devrait aussi être en mesure de distinguer plusieurs visages et de se focaliser sur l’un d’entre eux.

Contexte de l’étude

Un sondage réalisé auprès de personnes malvoyantes a révélé que celles-ci accordaient une grande importance à pouvoir interpréter des expressions faciales pendant une conversation. Elles ont également estimé important de pouvoir savoir quelle heure il était. Bien que nombre de personnes utilisent leur smartphone pour lire l’heure, il est encore fréquent de recourir à des montres analogiques. Les personnes âgées surtout portent encore volontiers une montre-bracelet. Comme indiqué ci-dessus, l’application est en cours de développement pour la reconnaissance d’expressions faciales. Pour pouvoir continuer à développer ces prototypes, une étude a d’abord cherché à répondre à la question suivante: quel type de présentation d’une information est la plus simple et la plus rapide à reconnaître pour les cas d’application décrits ci-dessus. Pour les chercheurs, il y a deux types d’informations à transmettre:

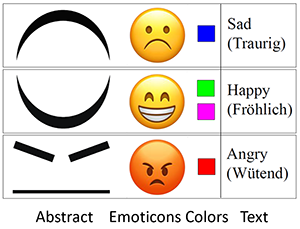

- Alphanumérique (mot, lettre, livre): le contenu de l’information n’est pas limité.

- Symbolique (panneau routier, émoticônes, cadran d’une montre, etc.): peut être perçu plus rapidement, le contenu de l’information est limité.

Structure de l’étude

Trois personnes (P1, P2 & P3) malvoyantes (âgées de 20, 24 & 81 ans, avec une vision de 0,04, 0,14 & 0,17) ont participé à l’étude. La première tâche des participants consistait à donner l’heure aussi vite que possible. Sur une montre-bracelet et sur la paire de lunettes de réalité augmentée HoloLens de Microsoft La deuxième tâche consistait à reconnaître aussi vite que possible des expressions faciales. La forme de restitution pouvait être choisie de manière autonome. Il y avait à choix des émoticônes, du texte («triste», «joyeux», «en colère») ou des couleurs.

Informations complémentaires sur l’étude:

- L’application de réalité augmentée a été développée avec les outils Unity 3D & Mixed Reality de Microsoft. L’application a été implantée dans une paire de HoloLens.

- L’app a été implémentée en Java sur la montre-bracelet. L’écran tactile de la montre sert de dispositif de saisie.

- La représentation agrandie sur HoloLens a été déclenchée par un geste de réveil ou en tapotant l’écran de la montre connectée. L’utilisateur peut aussi ajuster à sa guise le type d’affichage, sa couleur, sa clarté et sa position.

- Pour la reconnaissance des expressions faciales, une sélection aléatoire d’expressions faciales est affichée.

Résultats de l’étude

Reconnaissance de l’heure:

- Que l’heure soit affichée sous forme numérique ou symbolique, les utilisateurs ont pu lire plus rapidement l’heure avec HoloLens.

- La présentation numérique de l’heure a été reconnue plus rapidement que la présentation symbolique.

- L’acuité visuelle et la perception visuelle personnelle influencent les résultats. P2 et P3 (avec une vision similaire) ont obtenu des résultats très semblables, hormis en ce qui concerne l’affichage numérique sur la montre-bracelet. Malgré une vision légèrement supérieure, P3 a indiqué que cet affichage était difficile à lire, car les chiffres sont très proches et se recoupent visuellement. Pour s’acquitter de cette tâche, P3 a eu besoin de plus de temps.

Reconnaissance d’expressions faciales:

- Pour une représentation abstraite et en couleurs, les deux participants ont eu des temps de réaction identiques, alors que pour le texte et les émoticônes, P1 a eu besoin de plus de temps que P2.

- Les temps de réponse pour la représentation abstraite et en couleurs présentent quelques légères variations. D’autre part, le texte et les émoticônes ont des valeurs identiques, mais une variabilité plus élevée. P1 avec une vision de 0,04 a eu besoin de plus de temps pour percevoir et traiter les informations que P2 avec une vision de 0,14. Cela signifie que les représentations symboliques simples peuvent être perçues de manière identique par la plupart des utilisateurs et que des symboles plus détaillés ou des représentations alphanumériques dépendent de l’acuité visuelle.

Généralités:

- Les représentations alphanumériques et symboliques complexes sont plus fortement influencées par l’acuité visuelle mais offrent un meilleur flux d’informations.

- Les représentations symboliques simples peuvent être facilement reconnues facilement par un cercle d’utilisateurs plus important, mais sont limitées en ce qui concerne le flux d’informations. Il faudrait donc utiliser des symboles pouvant être différenciés visuellement et éviter le texte.

- Les représentations devraient être aussi simples que possible, par ex. privilégier les couleurs aux émoticônes.

Avantages de cette solution

- Adaptation de l’affichage en fonction des besoins des personnes avec un handicap visuel.

- Reconnaissance des symboles pouvant être simplifiée par un affichage simple.

- Les mains sont libres pendant l’utilisation de HoloLens.

- À l’avenir, les lunettes de réalité augmentée seront davantage utilisées et la gêne éprouvée à les porter va diminuer.

Champs d’application possibles de l’application finale pour Technologie et innovation

La démarche est très prometteuse. À notre avis, la solution pourrait être utilisée dans les domaines suivants:

- reconnaissance d’objet et représentation agrandie pour naviguer de manière sûre dans le trafic urbain: reconnaissance de panneaux routiers, passages piétons ou feux de circulation

- Affichage agrandi sous forme d’épingles des centres d’intérêt (Point of Interest POI) ou points d’itinéraire pendant la navigation

- Reconnaissance de pictogrammes (taxi, bus, stand d’information): L’utilisateur pourrait ainsi naviguer seul d’un quai de gare vers la sortie jusqu’à un arrêt de bus ou une station de taxi.

- Reconnaissance des émotions et gestes des auditeurs pendant une présentation: l’orateur peut ainsi répondre de manière ciblée aux questions ou réagir à l’humeur du public.

- Reconnaissance de certains symboles sur des emballages de produits: recherche de certaines icônes, par exemple le symbole du four et l’indication sur la durée de cuisson d’une pizza.

- Reconnaissance de postes pendant une course d’orientation

Sources

- Article «Augmented Reality for People with Low Vision: Symbolic and Alphanumeric Representation of Information»: https://link.springer.com/chapter/10.1007/978-3-030-58796-3_19

- Microsoft HoloLens: https://www.microsoft.com/de-de/hololens