ICCHP 2020: «Augmented Reality» für Sehbehinderte

Autor: Technologie und Innovation / SBV / Dezember 2020

Original-Titel: «Augmented Reality for People with Low Vision: Symbolic and Alphanumeric Representation of Information» (Florian Lang, Albrecht Schmidt, und Tonja Machulla)

Viele Hilfsmittel für sehbehinderte Menschen reizen die Vorteile von technischen Entwicklungen noch viel zu wenig aus. So sind «Augmented-Reality-Brillen» (AR-Brillen) in der Lage, schwer wahrnehmbare Informationen in ein für den Nutzer gewünschtes visuelles Format zu bringen.

Die Forscher der Ludwig-Maximilians-Universität in München haben eine AR-Anwendung in Planung, mit der es unter anderem möglich sein soll, Gesichtsausdrücke zu erkennen und die Bedeutung vergrössert auf der AR-Brille darzustellen. Die App soll auch in der Lage sein, zwischen mehreren Gesichtern zu unterscheiden und eines in den Fokus zu stellen.

Motivation der Studie

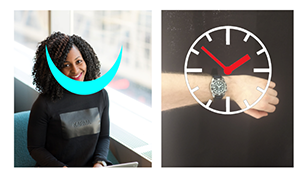

Aus einer Umfrage mit Sehbehinderten Menschen ging hervor, dass es ihnen wichtig ist, Gesichtsausdrücke während einer Konversation zu deuten. Auch empfanden sie es für wichtig, die aktuelle Uhrzeit zu erfahren. Obwohl viele Nutzer ihr Smartphone benutzen, um die Zeit zu prüfen, sind noch viele analoge Uhren im Einsatz. Zum Beispiel wollen noch viele ältere Menschen eine klassische Armbanduhr tragen. Für die Erkennung von Gesichtsausdrücken ist wie oben beschrieben eine App in Arbeit. Um diesen Prototypen weiterentwickeln zu können, musste mit einer Studie aber zuerst folgende Frage beantwortet werden: Welche Art der Präsentation einer Information ist am einfachsten und am schnellsten zu deuten für die oben beschriebenen Anwendungsfälle? Laut den Forschern gibt es dabei zwei Arten Informationen zu vermitteln:

- Alphanumerisch (Wort, Brief, Buch): Hier ist der Informationsgehalt nicht begrenzt.

- Symbolisch (Strassenschild, Emoticons, Ziffernblatt einer Uhr, etc.): Kann schneller wahrgenommen werden, Informationsgehalt begrenzt.

Aufbau der Studie

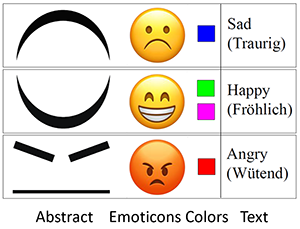

Teilnehmer der Studie waren drei (P1, P2 & P3) sehbehinderte Nutzer (20, 24 & 81 Jahre alt, Visus 0.04, 0.14 & 0.17). In der ersten Aufgabe mussten die Teilnehmer die Uhrzeit so schnell wie möglich ablesen. Auf einer Armbanduhr und auf der AR-Brille HoloLens von Microsoft. In der zweiten Aufgabe mussten Gesichtsausdrücke so schnell wie möglich erkannt werden. Die Ausgabeform konnte selbst ausgewählt werden. Zur Auswahl standen Emoticons, Text («traurig», «fröhlich», «wütend») oder Farben.

Weitere Details zur Studie:

- Die AR-Anwendung wurde mit Unity 3D & Mixed Reality Toolkit von Microsoft entwickelt. Die Anwendung wurde auf eine HoloLens übertragen

- Die App wurde auf der Armbanduhr in Java implementiert. Das Touch-Screen der Uhr dient als Input

- Die vergrösserte Darstellung auf der HoloLens wird durch eine Weckgeste oder ein Tippen auf das Display der Smartwatch ausgelöst. Auch hier konnte der Benutzer die Art, Farbe, Helligkeit und Position der Darstellung entsprechend den persönlichen Präferenzen anpassen.

- Für die Erkennung von Gesichtsausdrücken wurde eine zufällige Auswahl von Gesichtsausdrücken angezeigt.

Ergebnisse der Studie

Erkennung der Uhrzeit:

- Unabhängig davon, ob die Zeit numerisch oder symbolisch angezeigt wurde: Die Nutzer konnten die angezeigte Uhrzeit mit der HoloLens schneller ablesen

- Numerische Präsentation der Uhrzeit wurde schneller erkannt als symbolische.

- Die Sehschärfe und die persönliche Sehwahrnehmung beeinflussen die Ergebnisse. P2 und P3 (mit einem ähnlichen Visus) haben sehr ähnlich abgeschnitten, abgesehen von der numerischen Anzeige auf der Armbanduhr. Trotz des etwas höheren Visus berichtete P3, dass diese Anzeige schwer zu lesen sei, da die Zahlen dicht beieinander liegen und sich visuell gegenseitig überladen. Daher benötigte P3 bei dieser Aufgabe mehr Zeit.

Erkennung von Gesichtsausdrücken:

- Für die abstrakte und farbige Darstellung hatten beide Teilnehmer ähnliche Antwortzeiten, für Text und Emoticons benötigte P1 länger als P2.

- Die Antwortzeiten für farbliche und abstrakte Darstellung weisen eine geringe Varianz auf. Andererseits haben Text und Emoticons ähnliche Werte, aber eine höhere Varianz. P1 mit einem Visus von 0,04 benötigte mehr Zeit zur Wahrnehmung und Verarbeitung der Informationen als P2 mit einem Visus von 0,14. Das bedeutet, das einfache symbolische Darstellungen von den meisten Benutzern gleichermassen wahrgenommen werden können und dass detaillierte Symbole oder und alphanumerische Darstellungen von der Sehschärfe abhängen

Generell:

- Alphanumerische und komplexe symbolische Darstellungen werden stärker von der Sehschärfe des Teilnehmers beeinflusst, bieten aber einen besseren Informationsfluss.

- Einfache, symbolische Darstellungen können von einem grösseren Nutzerkreis leicht erkannt werden, sind aber im Hinblick auf den Informationsfluss begrenzt. Daher sollten visuell unterscheidbare Symbole verwendet und Text vermieden werden

- Darstellungen sollten so einfach wie möglich sein, z.B. Farben über Emoticons wählen.

Vorteile dieser App-Lösung

- Anpassung der Darstellung an Bedürfnisse von sehbehinderten Menschen.

- Erkennung der Symbole kann durch eine einfache Darstellung vereinfacht werden.

- Während der Nutzung des HoloLens sind die Hände frei.

- In Zukunft werden AR-Brillen vermehrt zum Einsatz kommen und die Hemmschwelle, sie zu tragen, wird kleiner werden.

Mögliche Einsatzgebiete der fertigen App aus Sicht von Technologie & Innovation

Der Ansatz scheint sehr vielversprechend. Unserer Meinung nach könnte die Lösung in folgenden Gebieten zum Einsatz kommen:

- Objekterkennung und vergrösserte Darstellung zur sicheren Navigation im Strassenverkehr: Erkennung von Strassenschildern, Fussgängerstreifen oder Ampeln

- Vergrösserte Anzeige in Form von Stecknadeln von Point of Interests oder Routenpunkten während einer Routennavigation

- Erkennung von Piktogrammen (Taxi, Bus, Info-Stand): So könnte sich der Nutzer selbständig von einem Perron nach Draussen, zu einer Bushaltestelle oder Taxi-Standplatz navigieren lassen

- Erkennung von Emotionen und Gesten der Zuhörer während einer Präsentation: So kann die vortragende Person gezielt auf Fragen oder Stimmung der Zuhörer eingehen.

- Erkennung von bestimmten Symbolen auf Produkte-Verpackungen: Suche nach bestimmten Icons, wie z.B. Ofen-Symbol und Erfahren wie lange die Pizza gebacken werden muss.

- Erkennung von Posten während eines Orientierungslaufes.

Quellenverzeichnis

- Journal Article «Augmented Reality for People with Low Vision: Symbolic and Alphanumeric Representation of Information»: https://link.springer.com/chapter/10.1007/978-3-030-58796-3_19

- Microsoft HoloLens: https://www.microsoft.com/de-de/hololens